Appearance

模型管理

通过模型管理功能,简化用户需要通过环境变量的方式配置模型,省去繁杂操作。同时配置好的模型,可以在应用、知识库等领域快速切换,查看不同模型在不同领域的表现效果。

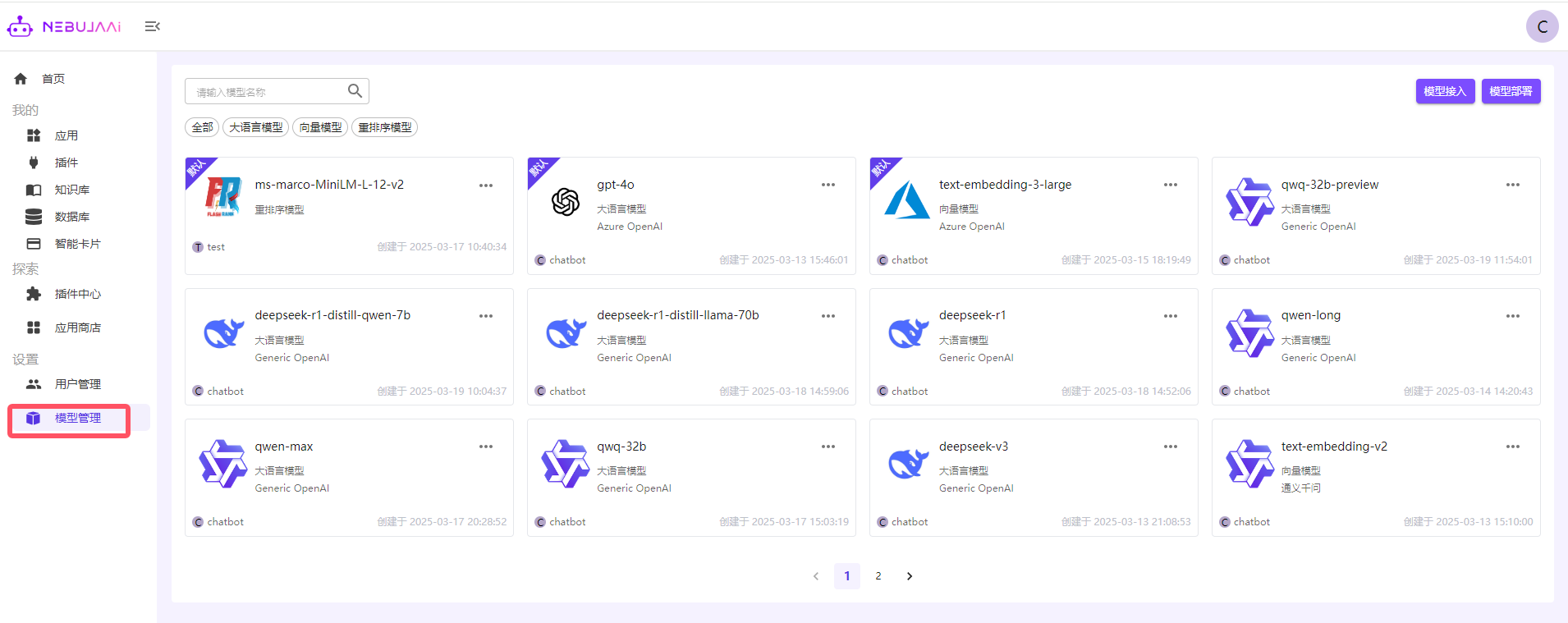

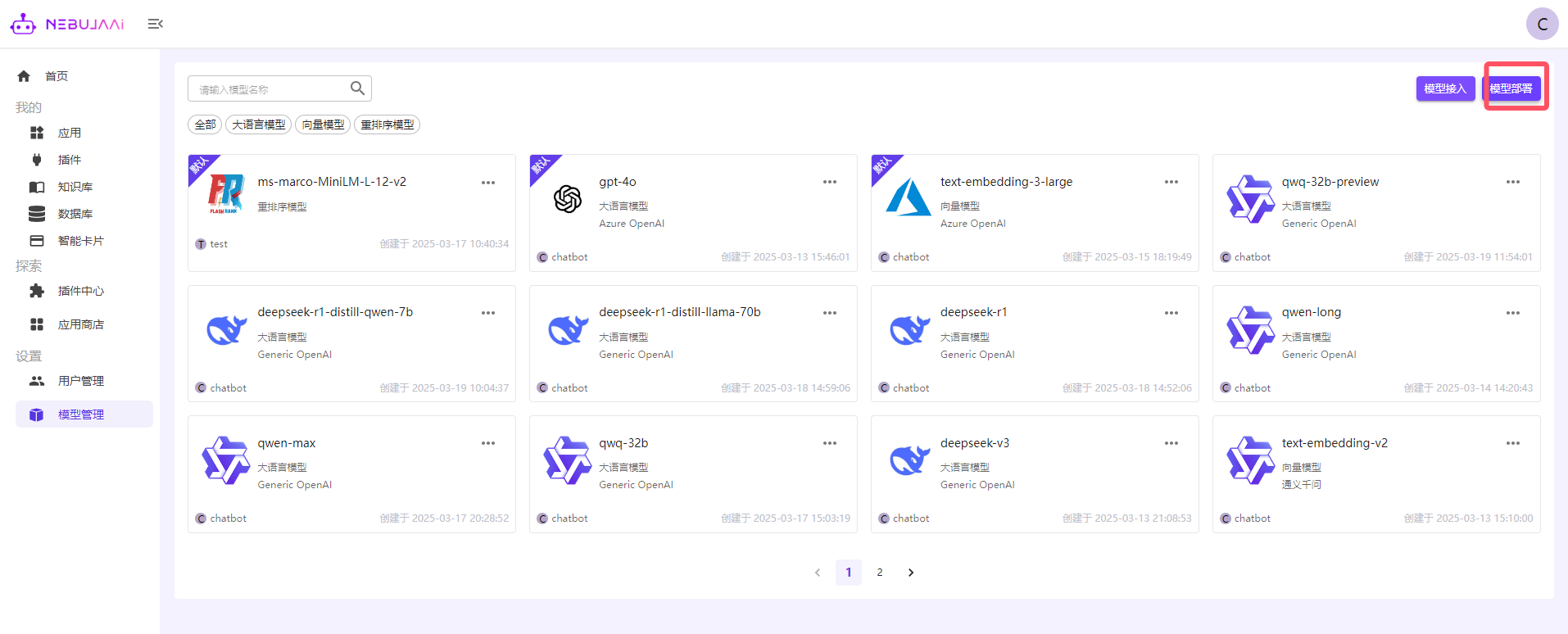

1. 模型列表

管理员进入设置,点击模型管理,即可查看已添加的模型。

2. 配置模型

通过模型接入添加公有或者私有模型,目前支持的模型类别有:

大语言模型:支持Azure OpenAI、OpenAI,以及兼容OpenAI调用方式的所有大语言模型。

向量模型:支持Azure OpenAI、OpenAI、兼容OpenAI调用方式的向量模型 、Ollama部署的向量模型、通义千问系列、HuggingFace系列、Cohere系列、Xinference部署的向量模型等。

重排序模型:支持OpenAI、兼容OpenAI调用方式模型、通义千问系列、Cohere系列、Jina等重排序模型。

下面以线上阿里云百炼官网、Deepseek官网以及Ollama本地部署的模型进行配置讲解:

2.1 在阿里云百炼上配置

本节将介绍如何从阿里云百炼官方网站上获取API key、模型名称和调用地址,以及如何接入到NebulaAI平台

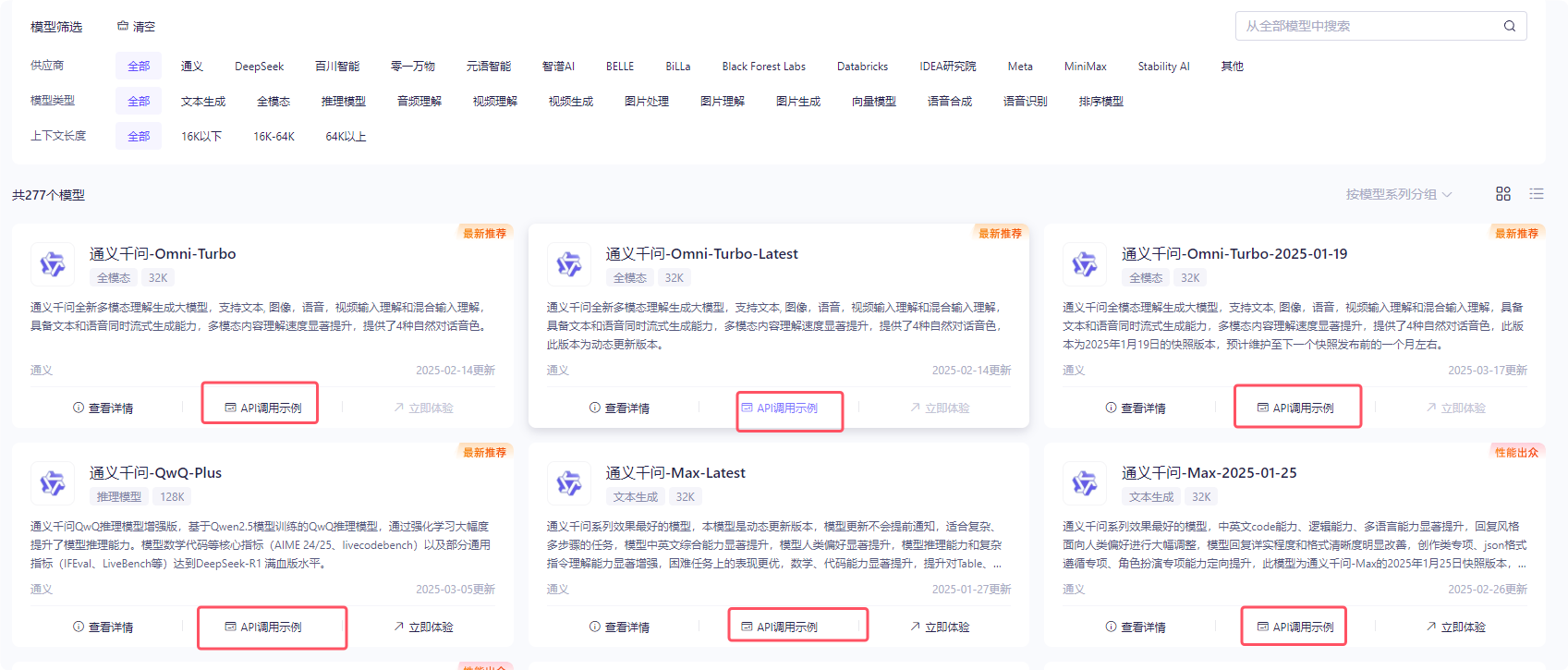

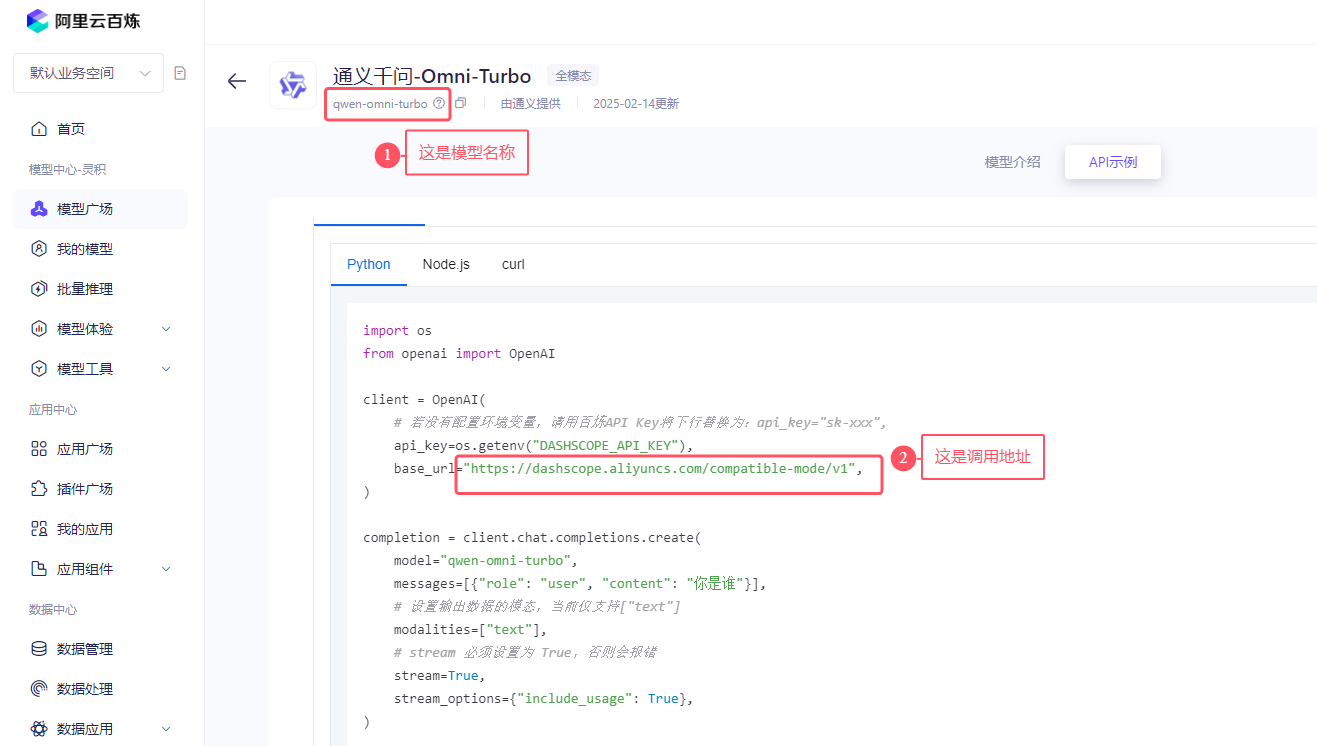

2.1.1 API key、模型名称和调用地址

右上角是申请的API-key,如果提示需开通百炼平台,直接开通即可,开通后不使用是不发生任何费用。点击进入创建自己的apikey, 选择任何一个模型,点击api调用示例:

如下图所示:找到模型名称,以及openai的调用示例中复制其调用地址。全部复制,包括域名和/v1. 将模型名称、apikey和调用地址填入即可。

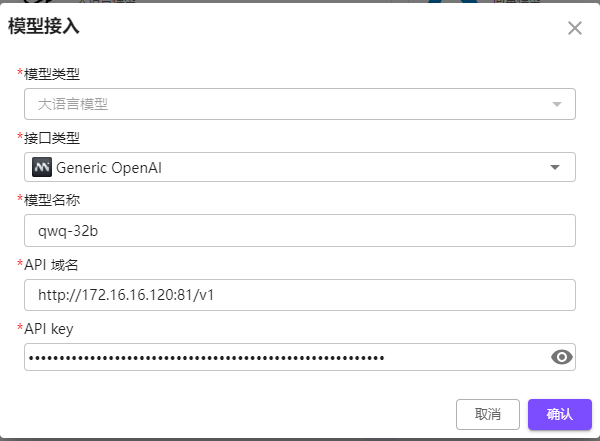

2.1.2 接入到NebulaAI平台

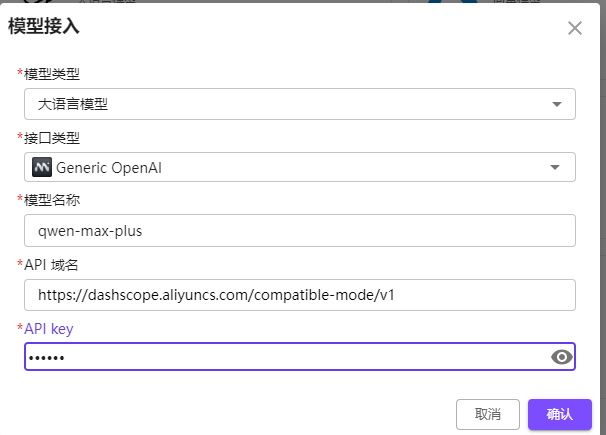

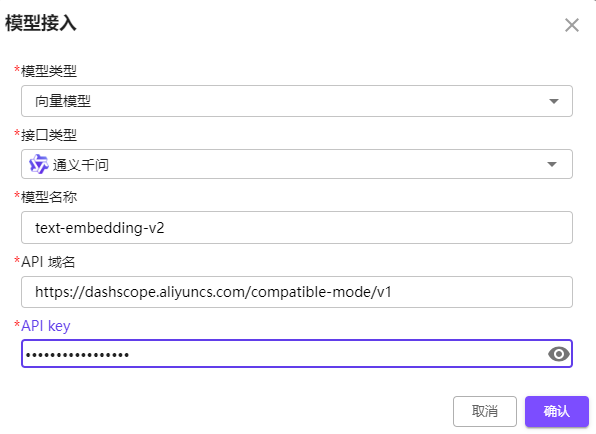

保存上一步的apikey,调用地址:https://dashscope.aliyuncs.com/compatible-mode/v1

大语言模型接入, 如下图所示:

向量模型接入,如下所示:

重排序模型接入,如下图所示:

2.2 配置Deepseek语言模型

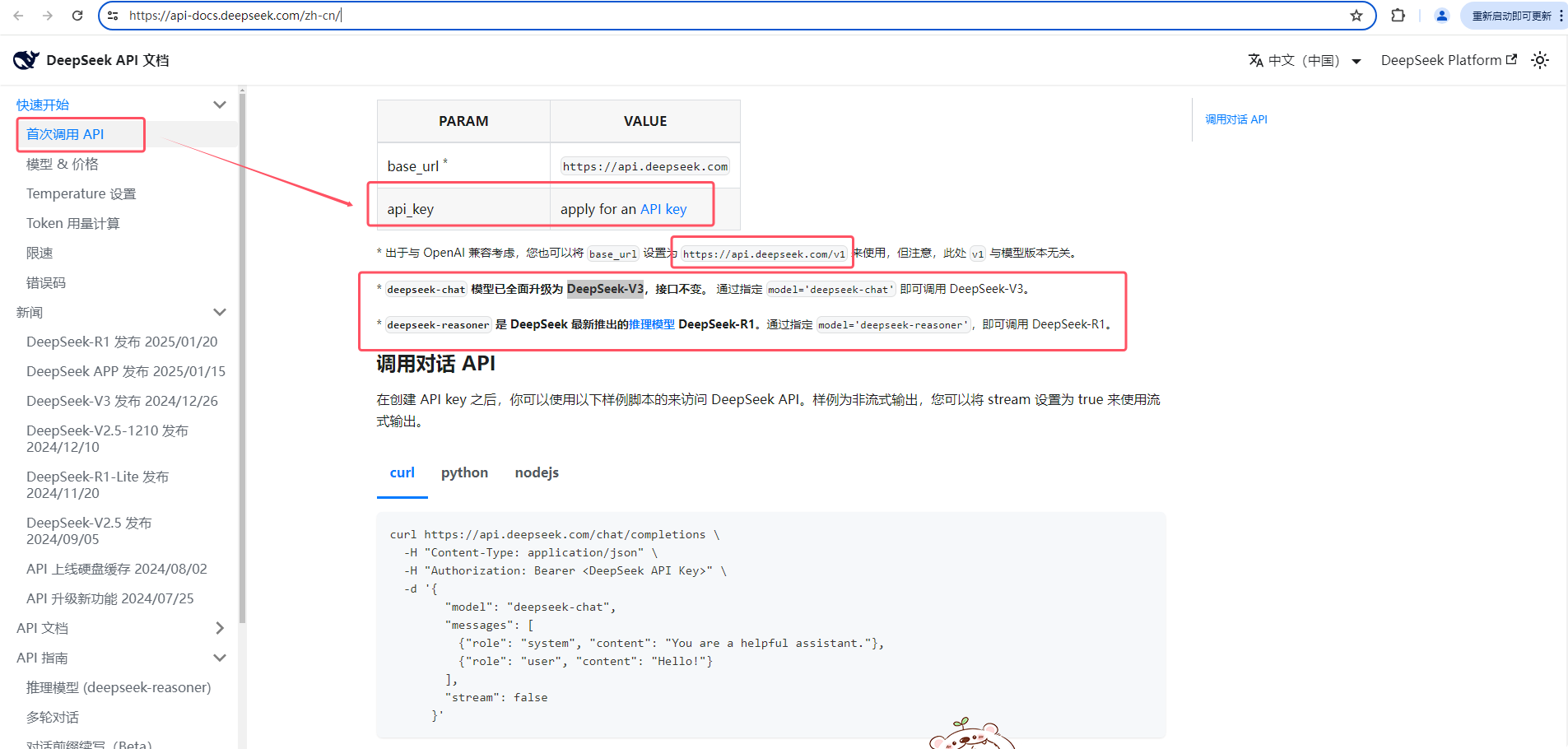

访问官方文档:https://api-docs.deepseek.com/zh-cn/

依次点击

快速开始-->首次调用API,如下图所示:申请apikey、查看openai的调用地址以及模型名称。

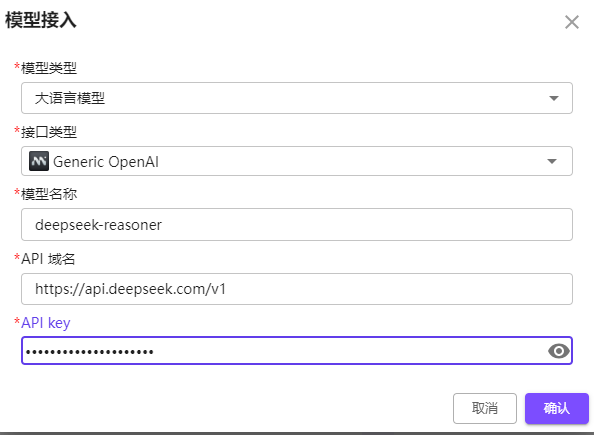

保存上一步apikey, 模型名称,调用地址(https://api.deepseek.com/v1),如下图所示:

2.3 ollama的配置

获取ollama的访问地址以及模型名称。

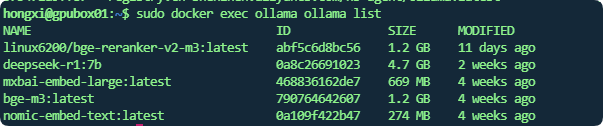

模型名称:可通过ollama list命令查看,docker部署的可以通过 sudo docker exec ollama ollama list 如下图所示:

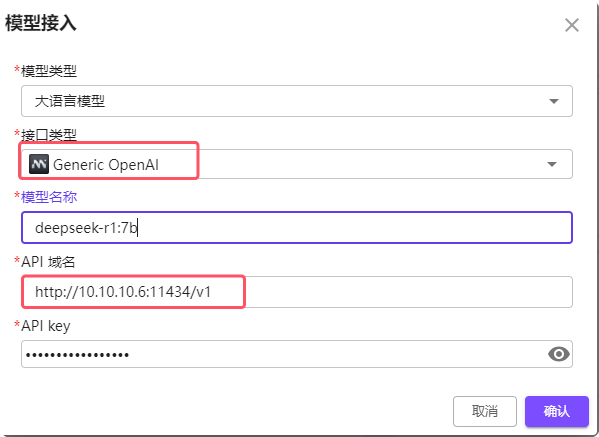

大语言模型:

api key如果没有配置则填写任意值。

调用地址:填写http://ollmahost:port/v1, 例如ollama所在的ip为10.10.10.6,端口为11434,则调用地址填写:http://10.10.10.6:11434/v1

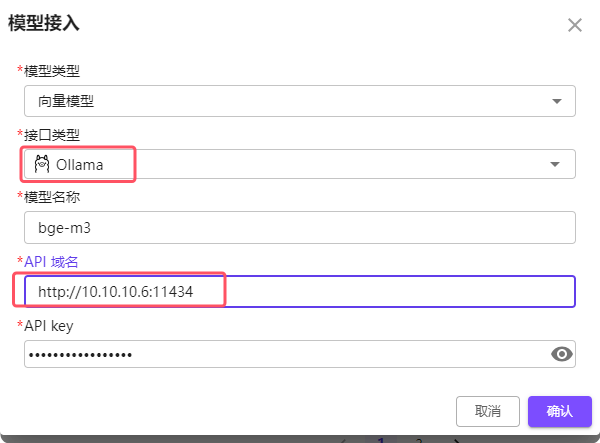

Embedding (向量)模型:

api key如果没有配置则填写任意值。

调用地址:填写http://ollmahost:port, 例如ollama所在的ip为10.10.10.6,端口为11434,则调用地址填写:http://10.10.10.6:11434. 注意大语言模型需要带上/v1,但是Embedding 模型不要带

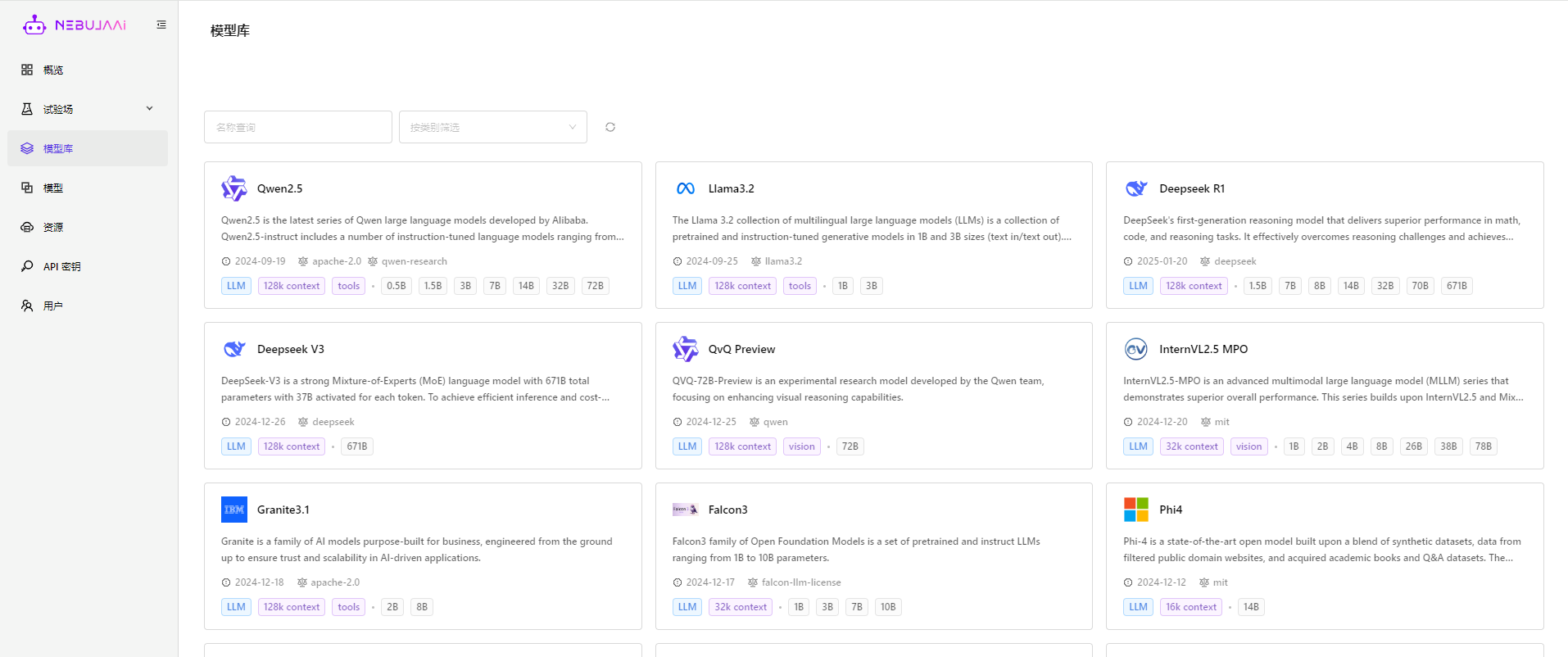

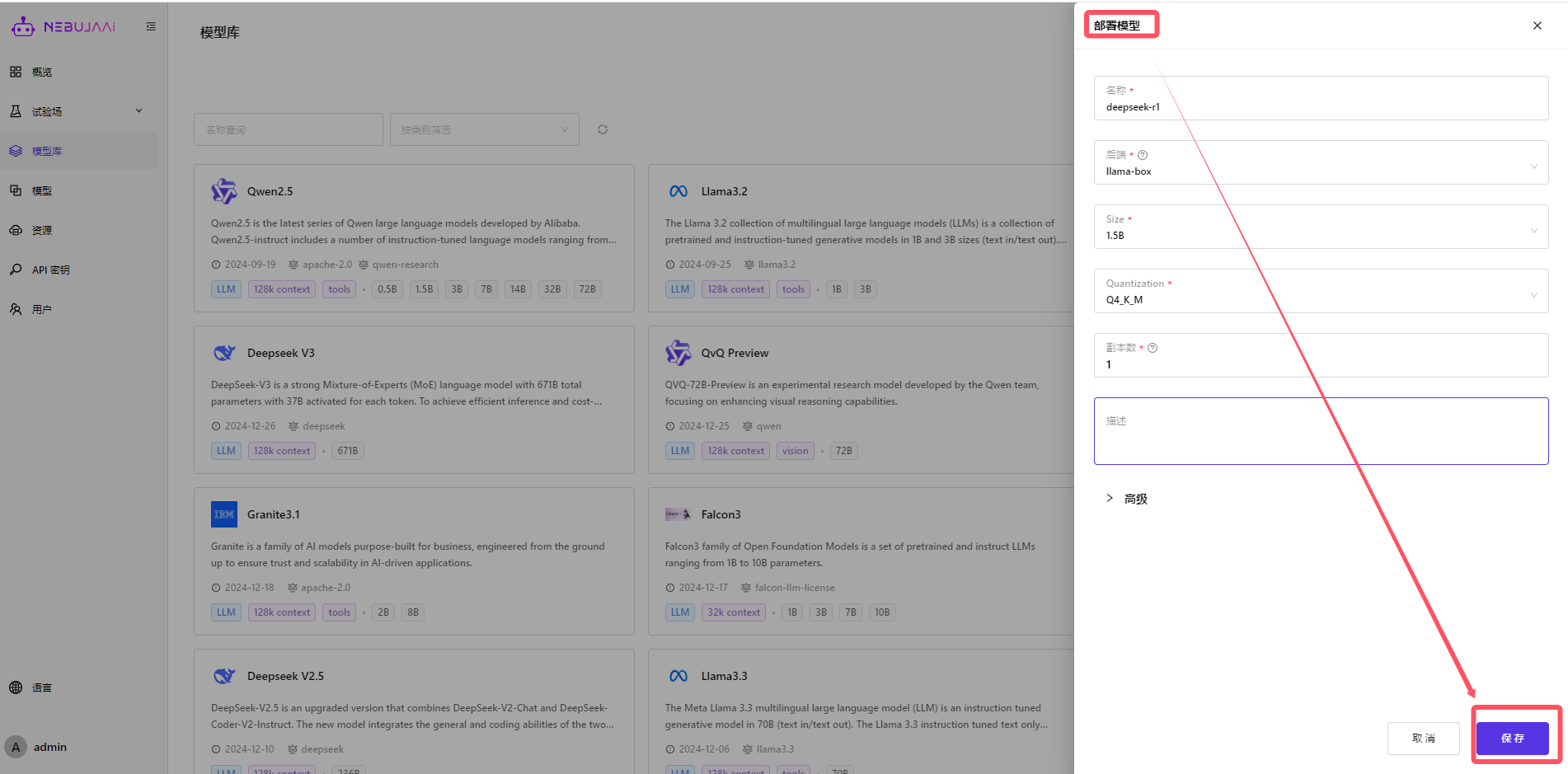

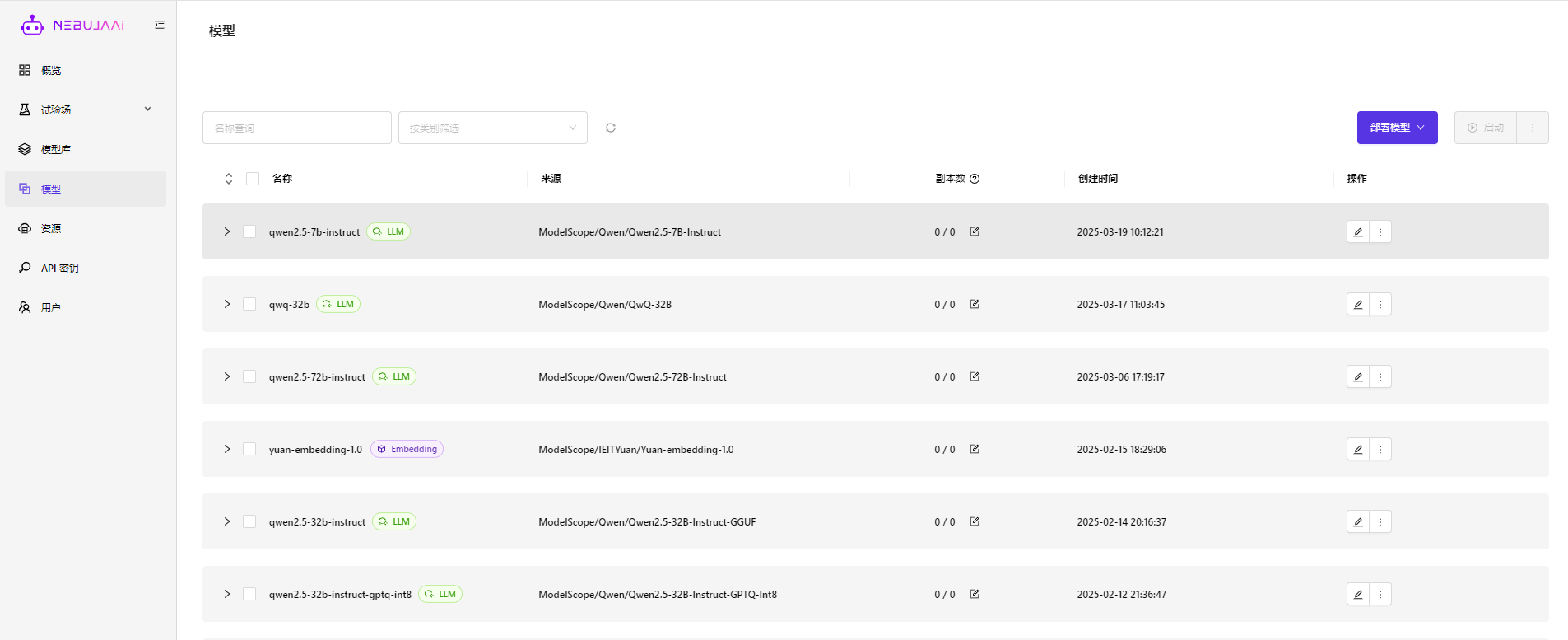

3. 模型部署

企业版提供一键模型部署功能。在模型管理列表页面,点击模型部署,进入到模型部署平台:

3.1 在模型库中可查看支持部署的模型,支持几乎所有的主流模型。

3.2 点击保存后,便自动下载模型,并进行部署

模型部署期间,可以在模型中查看模型部署状态

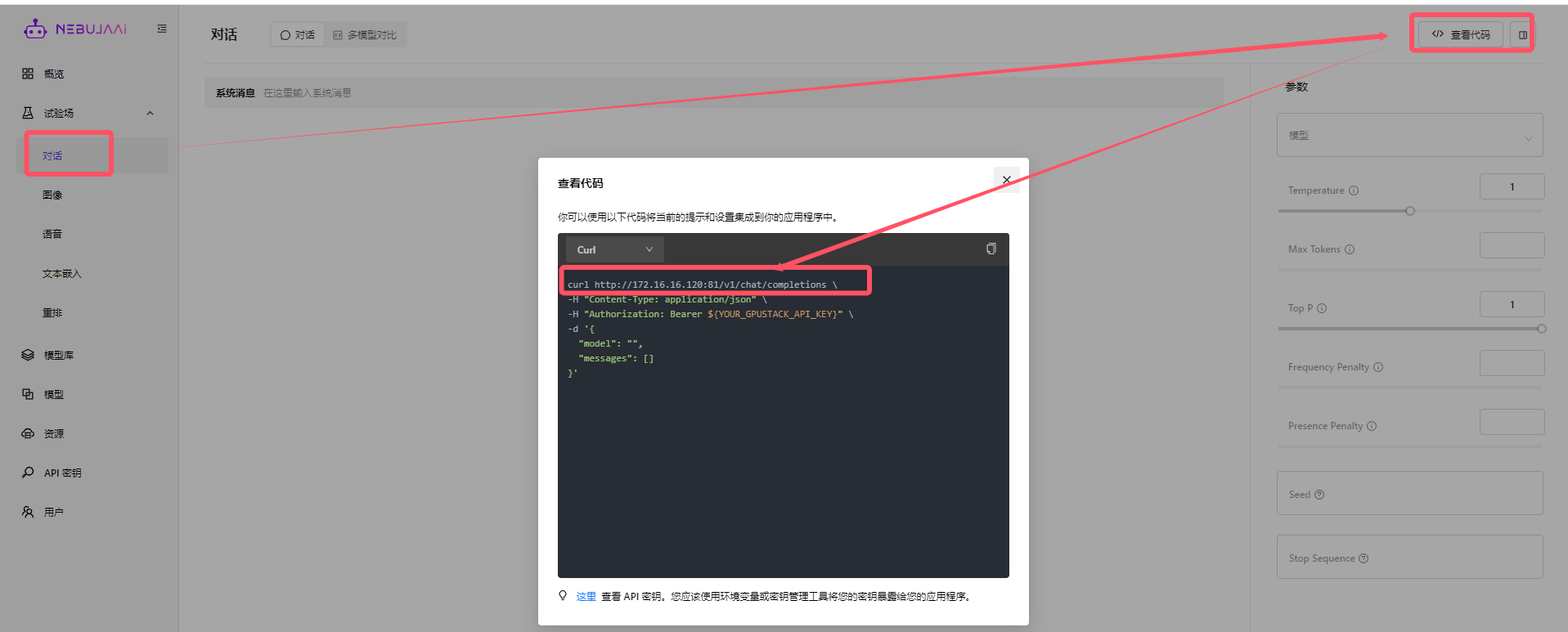

3.3 查看部署成功后的模型地址以及apikey

部署成功后查看调用地址

创建apikey

3.4 接入创建的模型。