Appearance

模型准备

下面以线上阿里云百炼官网、Deepseek官网以及Ollama本地部署的模型进行配置讲解

公有模型资源准备

2.1 在阿里云百炼上配置

本节将介绍如何从阿里云百炼官方网站上获取API key、模型名称和调用地址,以及如何接入到NebulaAI平台

2.1.1 API key、模型名称和调用地址

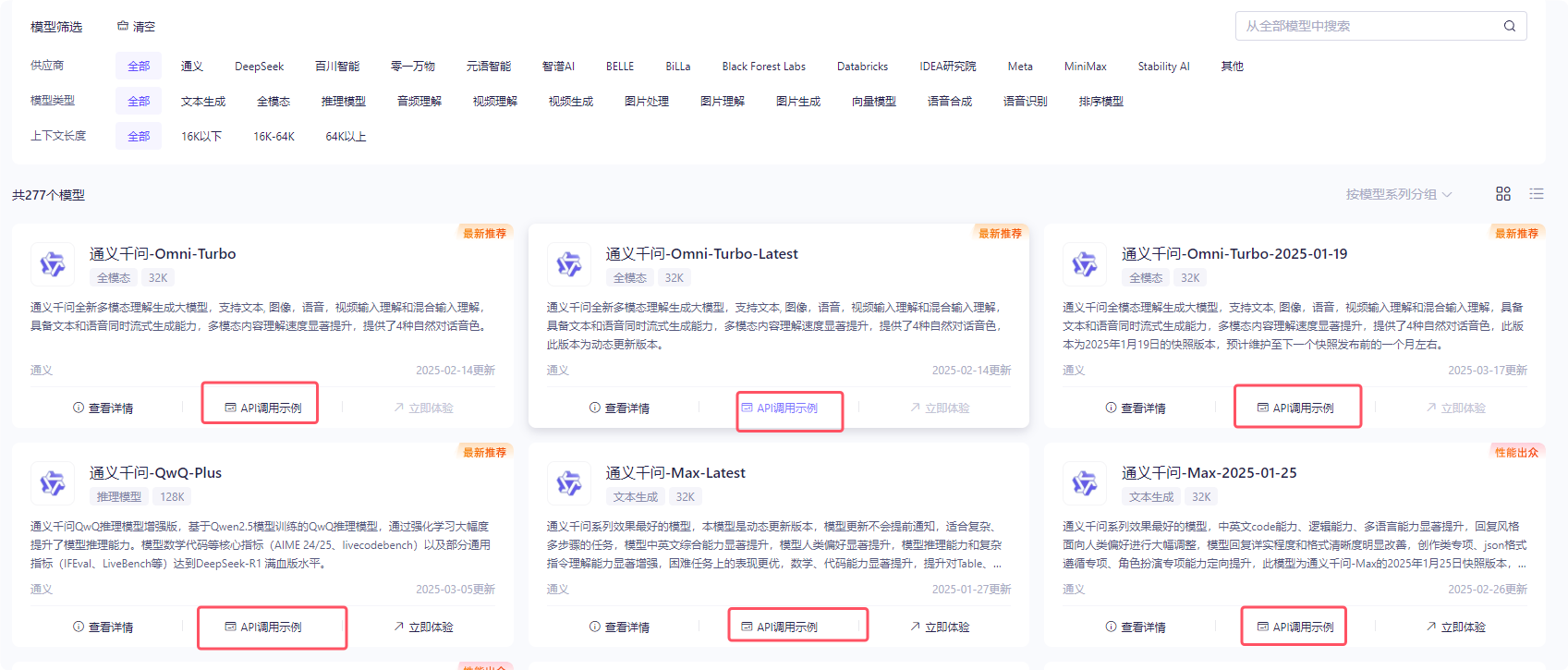

右上角是申请的API-key,如果提示需开通百炼平台,直接开通即可,开通后不使用是不发生任何费用。点击进入创建自己的apikey, 选择任何一个模型,点击api调用示例:

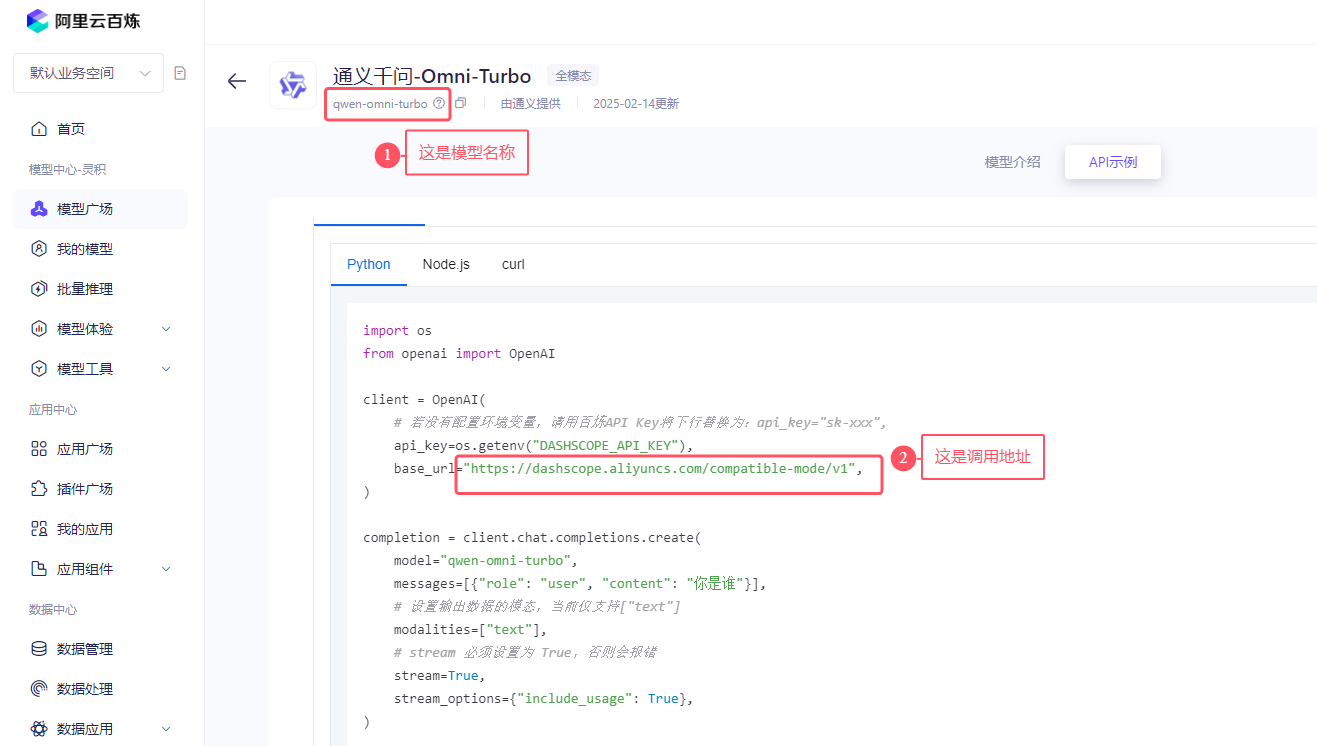

如下图所示:找到模型名称,以及openai的调用示例中复制其调用地址。全部复制,包括域名和/v1. 将模型名称、apikey和调用地址填入即可。

2.1.2 接入到NebulaAI平台

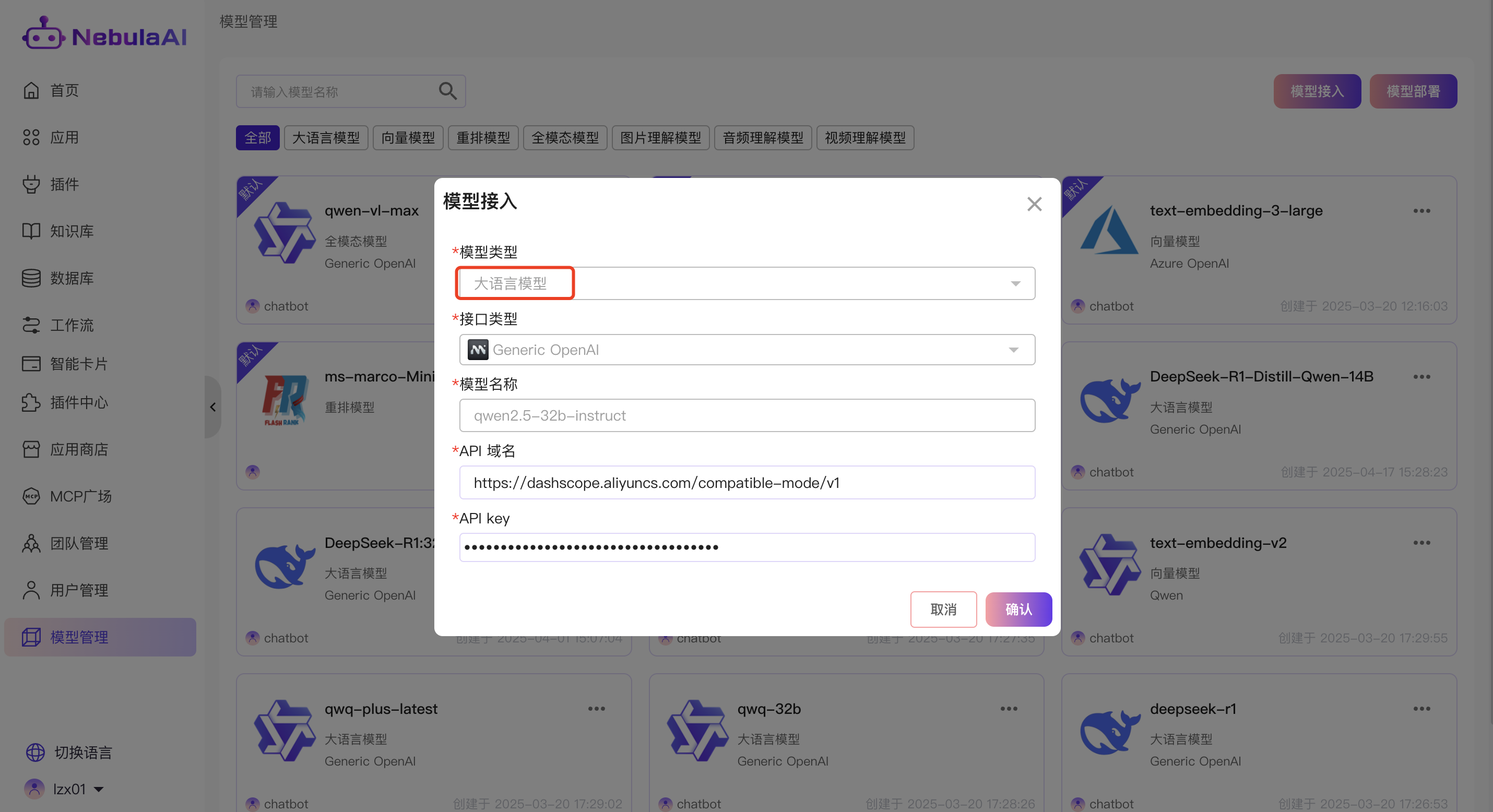

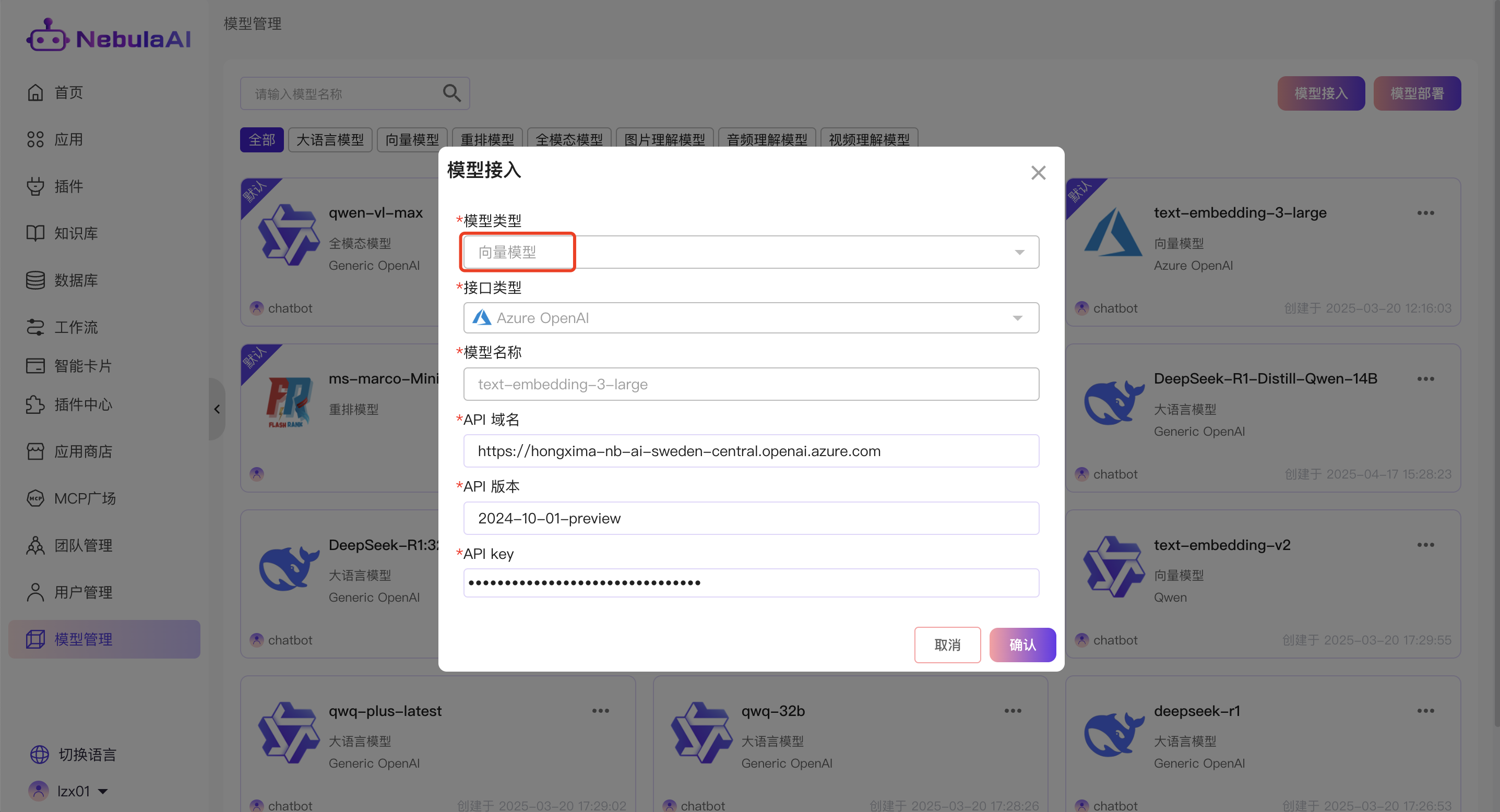

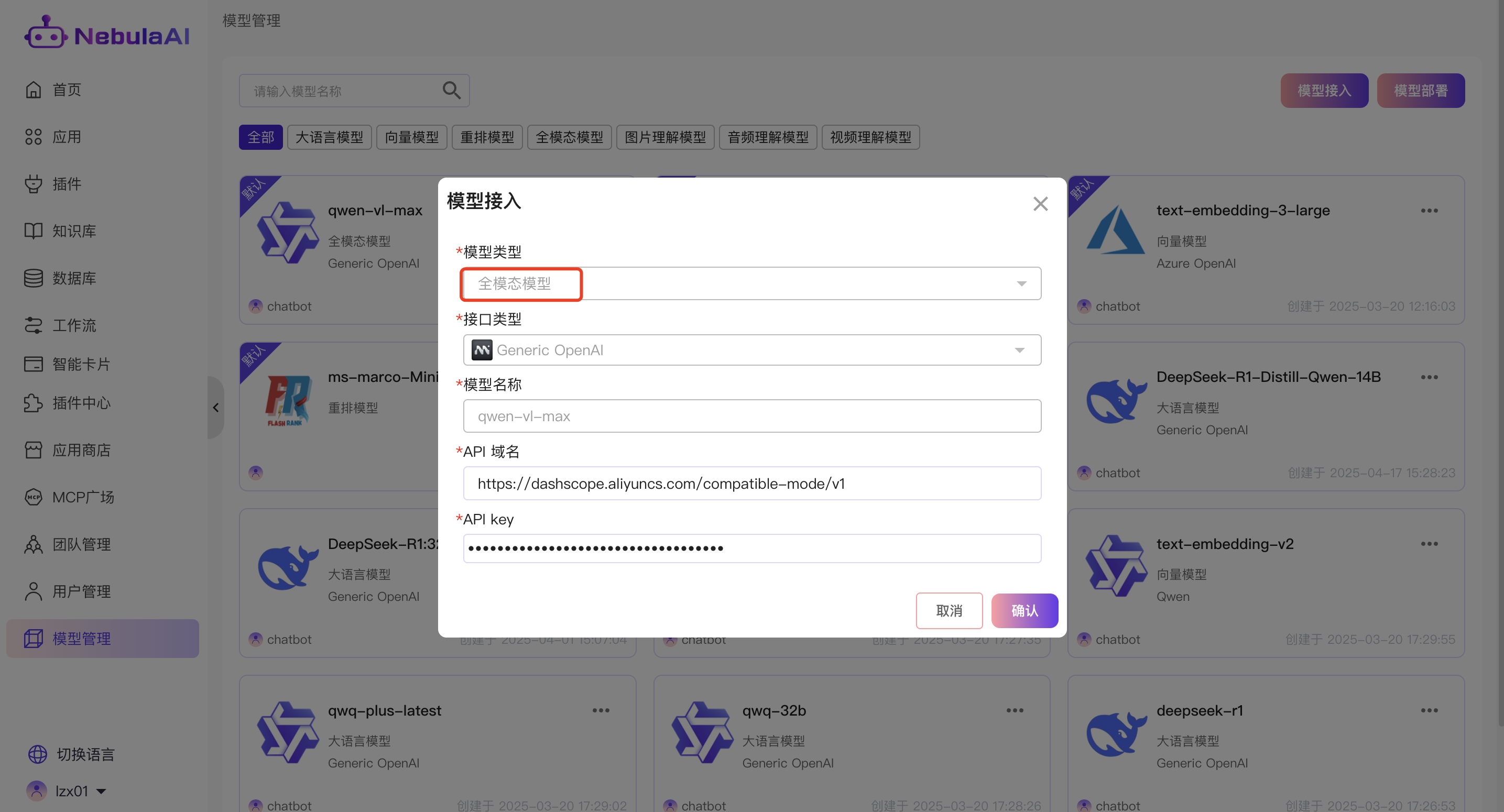

保存上一步的apikey,调用地址:https://dashscope.aliyuncs.com/compatible-mode/v1, 在设置->模型管理,点击"模型接入"操作,根据自己的实际需求,配置大语言模型、 向量模型【用于知识库创建和查询时需要】、重排序模型【非必须】、全模态模型【非必须】、图片理解模型【非必须】、音频理解模型【非必须】、视频理解模型【非必须】等

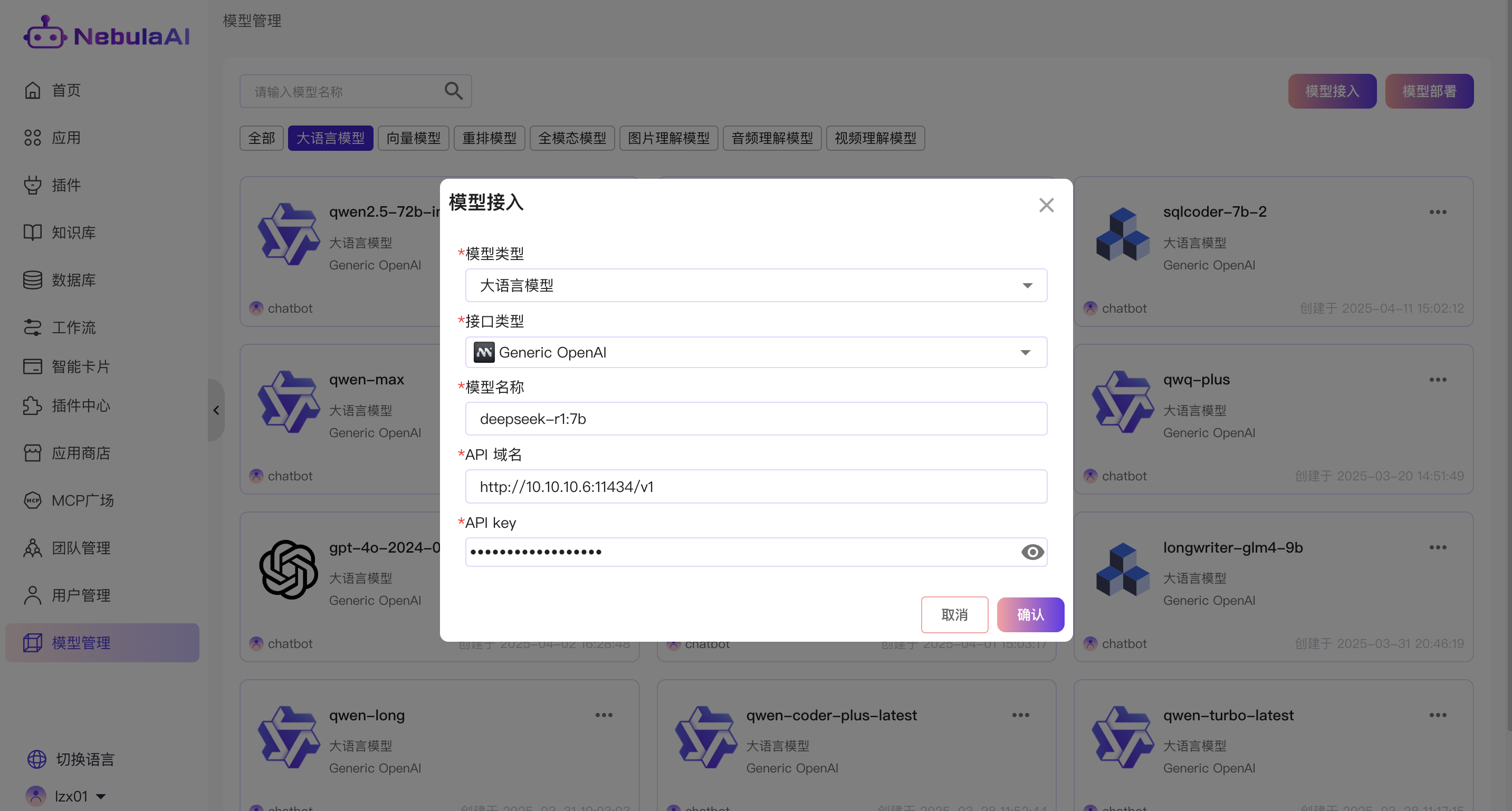

大语言模型接入, 如下图所示:

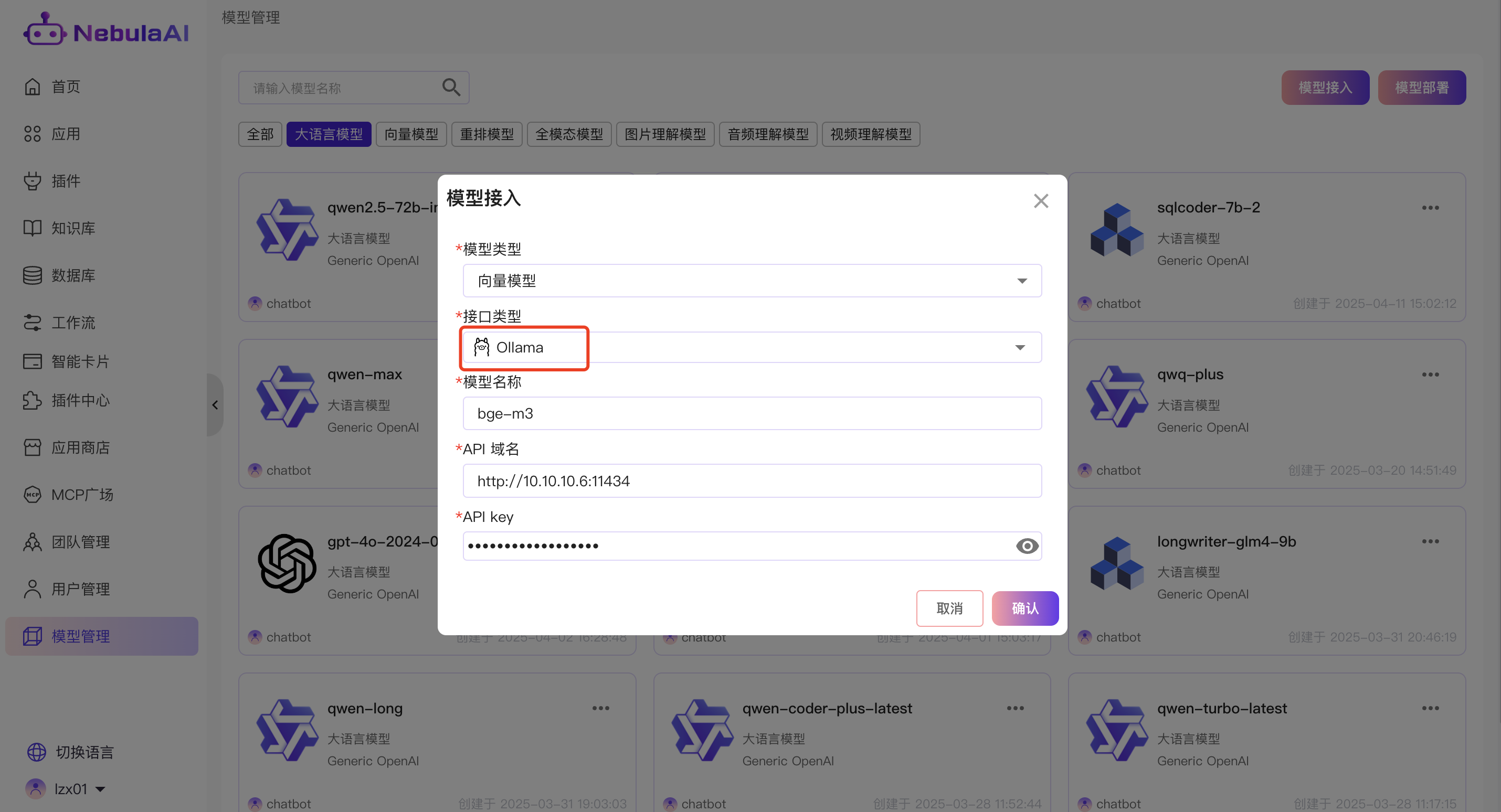

向量模型接入,如下所示:

其他如全模态模型接入,如下图所示:

2.2 配置Deepseek语言模型

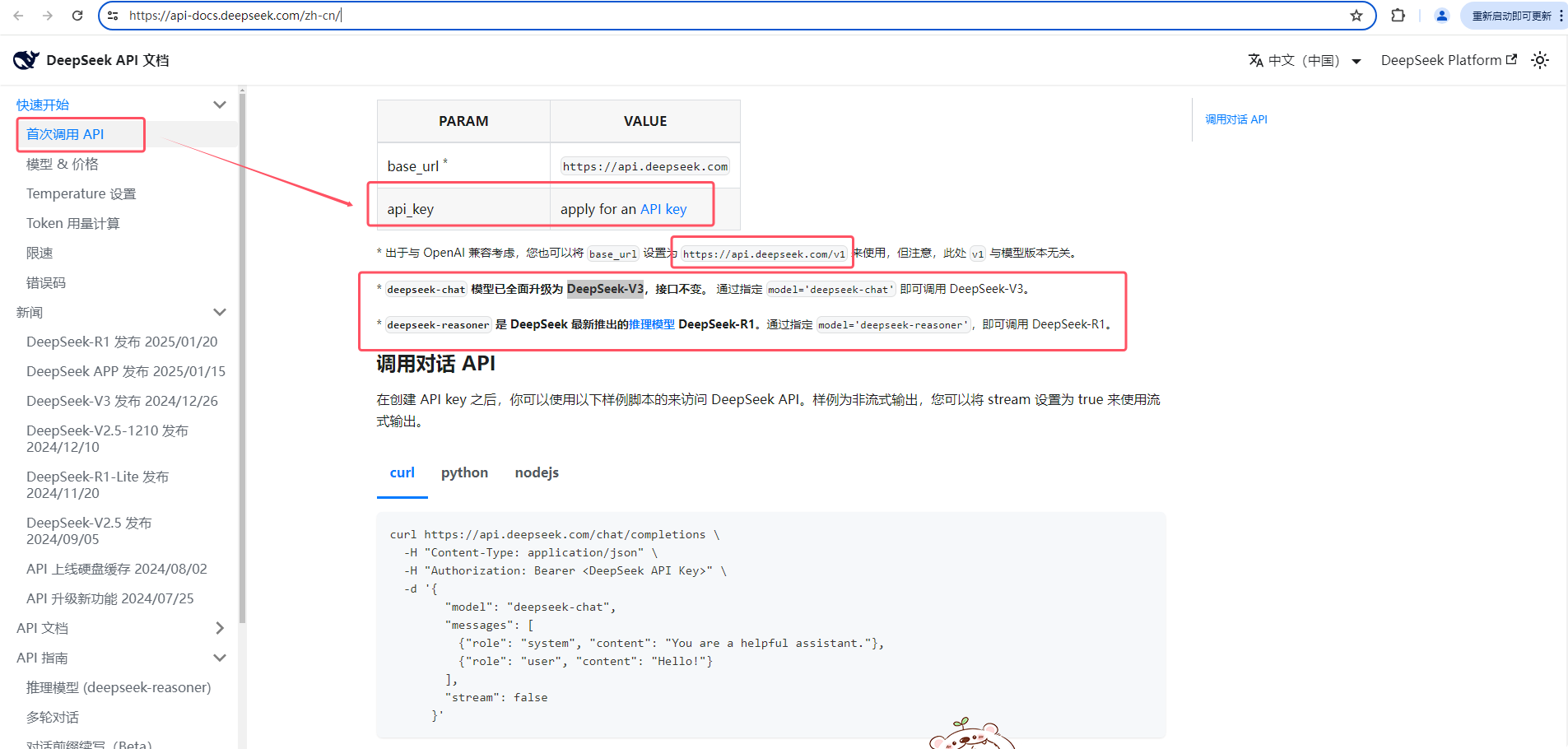

访问官方文档:https://api-docs.deepseek.com/zh-cn/

依次点击

快速开始-->首次调用API,如下图所示:申请apikey、查看openai的调用地址以及模型名称。

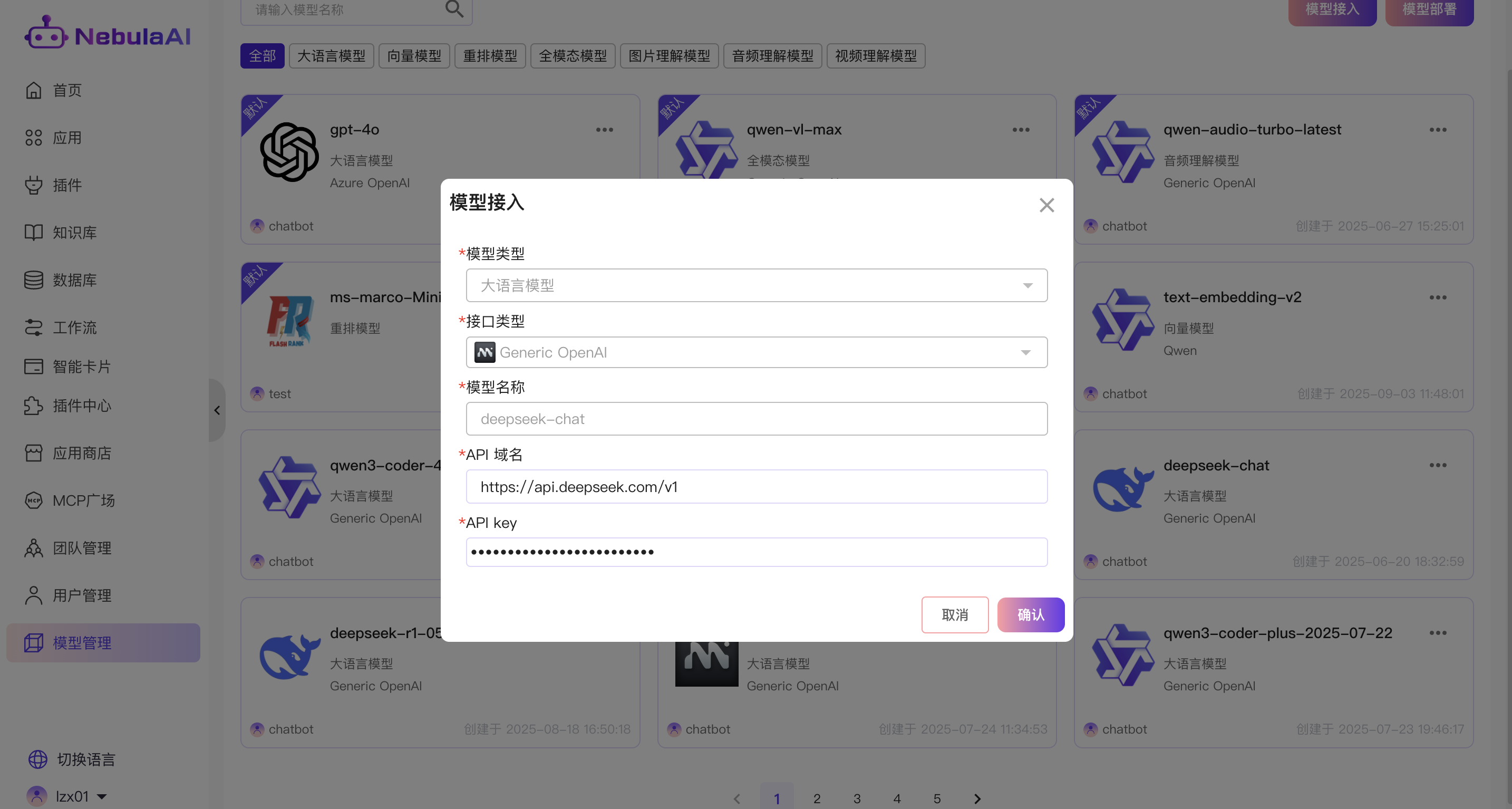

保存上一步apikey, 模型名称,调用地址(https://api.deepseek.com/v1),如下图所示:

本地模型准备

使用ollama方式部署模型

获取ollama的访问地址以及模型名称。

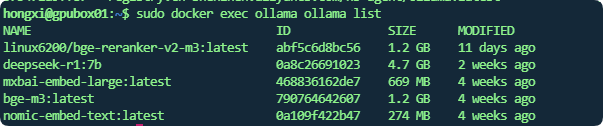

模型名称:可通过ollama list命令查看,docker部署的可以通过 sudo docker exec ollama ollama list 如下图所示:

大语言模型:

api key如果没有配置则填写任意值。

调用地址:填写http://ollmahost:port/v1, 例如ollama所在的ip为10.10.10.6,端口为11434,则调用地址填写:http://10.10.10.6:11434/v1

Embedding (向量)模型:

api key如果没有配置则填写任意值。

调用地址:填写http://ollmahost:port, 例如ollama所在的ip为10.10.10.6,端口为11434,则调用地址填写:http://10.10.10.6:11434. 注意大语言模型需要带上/v1,但是Embedding 模型不要带